Man sieht sie überall und man hört überall von ihnen: die künstliche Intelligenz. Immer mehr Programme und Apps arbeiten mit dieser neusten Technologie und funktionieren nur aufgrund von künstlicher Intelligenz. Auch die App Lensa funktioniert auf diese Weise und soll aus hochgeladenen Selfies wahre Kunstwerke machen. Allerdings gibt es laut User:innen da ein ziemlich großes Problem: Die App soll gegenüber Frauen extrem sexistisch sein. Wir haben uns angeschaut, was dahinter steckt und die App selbst ausprobiert, um den Vorwürfen auf den Grund zu gehen.

Das erwartet dich zum Thema „Lensa App“:

Das steckt hinter der viral gegangenen Lensa-App

Die App Lensa hat sich auf die Fahne geschrieben, basierend auf KI-Technologien künstlerische Porträts von User:innen zu generieren – anhand vorher hochgeladener Selfies. Die generierten Bilder sind also komplett auf dich und deine Person abgestimmt und könnten somit individueller nicht sein.

Die App selbst gibt es seit dem Jahr 2019, der Hype rund um diese hat aber erst jetzt begonnen und überschwemmt regelrecht die gesamte Welt. Vor allem seit der Erweiterung um das „Magic Avatar“-Feature wird sie mehr benutzt denn je. Lensa zählt bereits jetzt schon mehr als zehn Millionen Downloads – und könnte sich dementsprechend als erste, massentaugliche KI-App etablieren.

Wie funktioniert die Lensa-App?

Die Funktionsweise ist denkbar einfach. Man öffnet die App, lädt bis zu 20 Selfies, von einem hoch, gibt sein oder ihr Geschlecht an und lässt die KI ihren Job machen. Natürlich lassen sich die Entwickler:innen dies auch bezahlen und verlangen für 50 Fotos rund 4 Euro Einmalzahlung. Wenn du diese Zahlung bestätigt hast, musst du über 20 Minuten warten – um dann von der KI Dutzende Bilder zu bekommen, die in den unterschiedlichsten Kunststilen aus verschiedenen Epochen daherkommen.

Kritik an der Lensa-App: Extremer Sexismus gegenüber Frauen

An sich klingt das Konzept von Lensa spaßig: Man lädt ’normale‘ Selfies in die App und bekommt Kunstwerke von der KI ausgespuckt. Doch neben dem Fakt, dass sich die KI angeblich an den Kunststilen von einzelnen Künstler:innen bedient, die natürlich nicht namentlich genannt oder entlohnt werden, soll die App und deren Bearbeitung extrem sexistisch gegenüber Frauen sein.

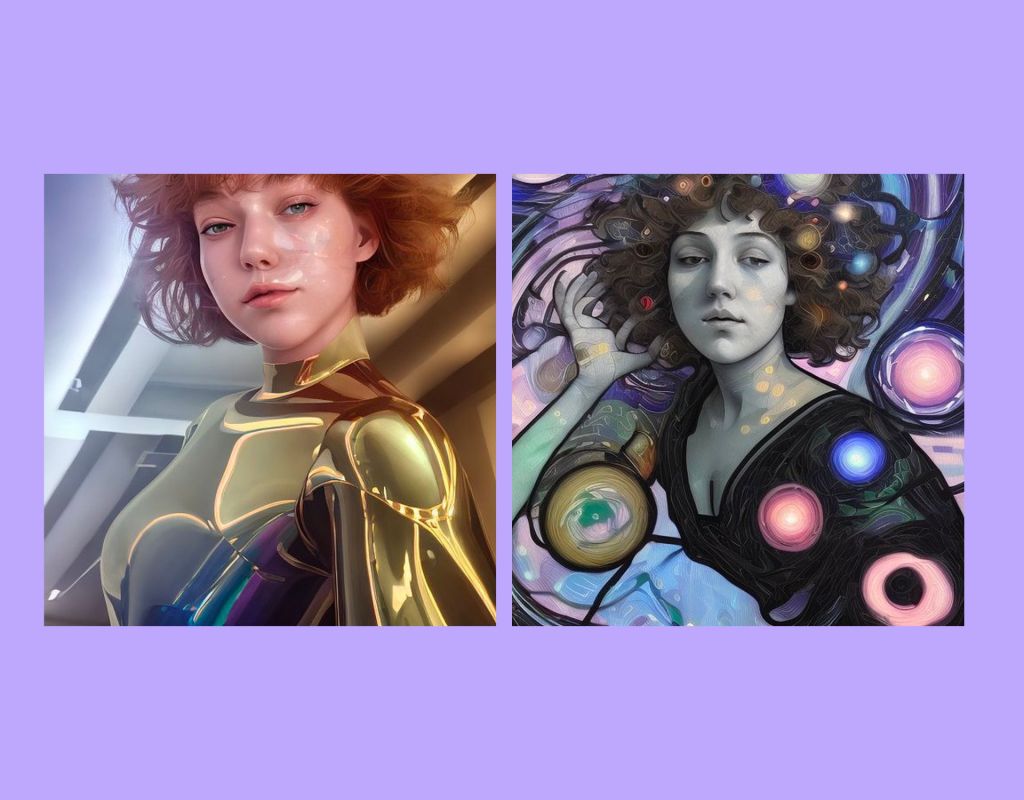

Denn die Frauen werden bei Lensa mehr als fragwürdig dargestellt – in meist körperbetonten Outfits, mit großer Oberweite oder manchmal sogar komplett nackt. Hier werden frauenfeindliche Bilder gezeichnet, die eigentlich nur basierend auf dem Gesicht entworfen werden, wie US-Aktivistin Brandee Barker der App vorwirft. Bei den Männern hingegen werden meistens Superhelden-Posen oder hochgeschlossene Anzüge von der KI gewählt.

Studien zeigen: KI’s lernen Sexismus regelrecht

Immer wieder wird künstlichen Intelligenzen vorgeworfen, dass sie angeblich mit verzerrten Wahrnehmungen durch Stereotypen arbeiten. Dies passiert unter anderem, wenn Algorithmen Vorurteile von Menschen übernehmen, die sie geschaffen haben. Da Männer in vielen Teilen der Gesellschaft noch immer als die „starken Superhelden‘ gesehen werden, wird dieses Ideal auch von der KI reproduziert – während Frauen hier überwiegend als Sexobjekt dargestellt werden.

Forscher:innen fanden sogar in mehrere Studien heraus, dass KI’s sogar implizite Vorurteile aufweisen. In acht von 15 Tests sollen die Modelle soziale Verzerrungen auf ähnliche Weise wie diejenigen zeigen, die Wissenschaftler:innen seit Jahrzehnten beim Menschen mit dem implizierten Bias-Test dokumentieren. Dieser besteht daraus, dass Menschen Fotos gezeigt werden, auf die sie mit einem „negativen oder positiven Knopf“ reagieren müssen. Ergebnisse zeigten über Jahre hinweg, dass Fotos, auf denen Frauen zu sehen sind, die etwas Banales tun, mit einem negativen Gefühl assoziiert wurden – und davon lernen die künstlichen Intelligenzen und eignen sich diesen Sexismus ebenfalls an.

Unbeaufsichtigte Modelle, die nicht auf Bilder trainiert werden, die von Menschen markiert wurden, lernen manchmal sogar einfach aus den Bildern selbst – auch wenn kein Mensch auf bestimmte Vorurteile aufmerksam gemacht hat. Doch auch überwachte Modelle sind Teil des Problems. Sie lernen durch Programme wie ImageNet, auf welchen eine Vielzahl von rassistischen, pornografischen und anderweitig problematischen Bildern enthalten sind. Und: Programme wie diese werden ständig mit neuen Bildern aus dem Internet aktualisiert, ohne die Zustimmung oder das Wissen der darauf abgebildeten Personen und ohne eine Möglichkeit des Rückgriffes.

- Noch mehr Insights gibt es hier:

- Andrew Tate: Der Niedergang des selbsternannten „Alpha Males“

- Loverboy Methode: So erkennst du sie

- Foto von Hilary Duff: Deswegen haben Frauen Angst vorm Älterwerden

Der Selbstest: Das passierte als wir die Lensa-App ausprobierten

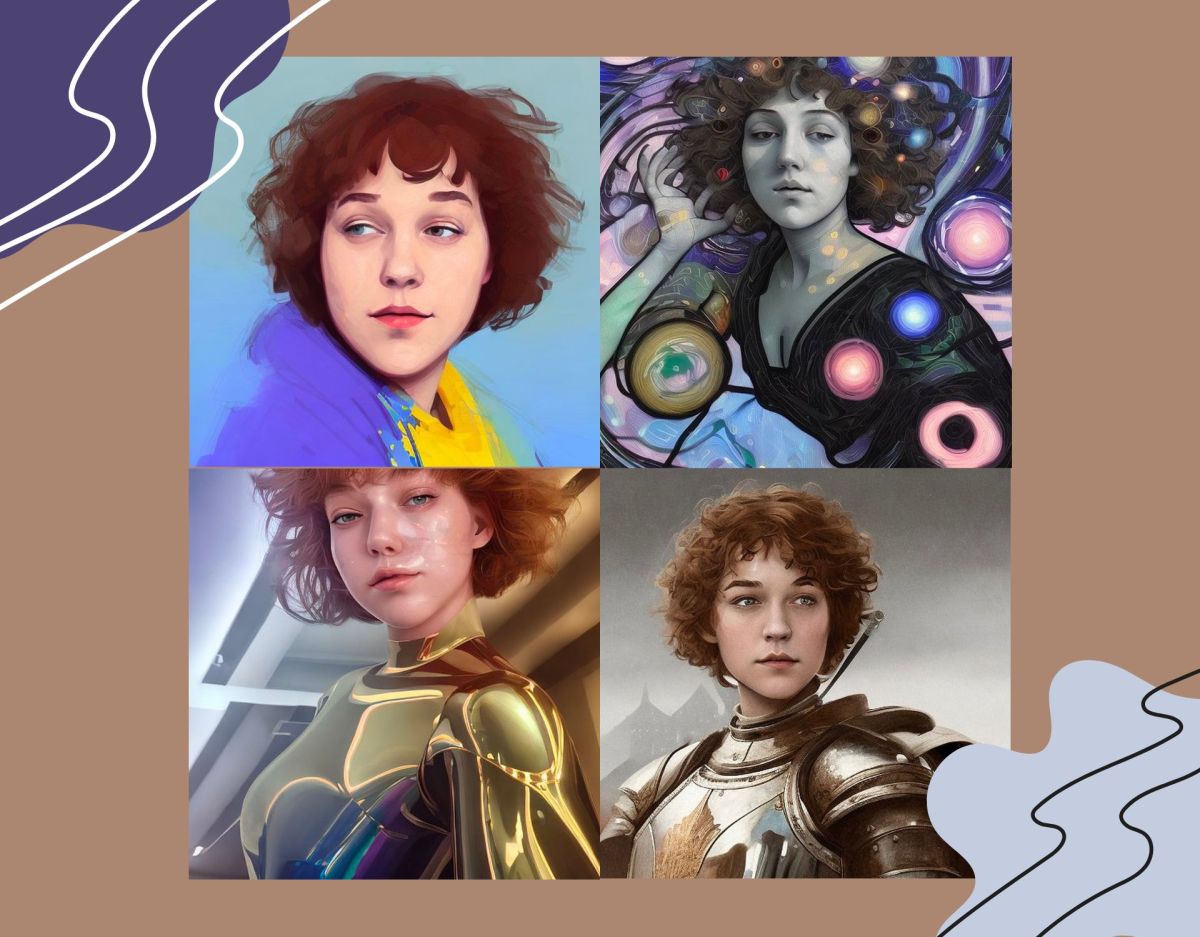

Natürlich konnte ich es mir nicht nehmen lassen, die Lensa-App selbst auszuprobieren. Nachdem ich erstmal Speicherplatz auf meinem Handy schaffen musste (Ja, die App ist ziemlich groß), lud ich um die 20 Selfies hoch. Ich mache selten welche und wenn, sehen sie meistens eher lustig als ästhetisch aus. In den meisten trage ich einen hochgeschlossenen Hoodie und wenig Make-Up. Ich musste also nun 20 Minuten warten und war gespannt, wie das Ergebnis aussehen würde.

Als ich mir die Fotos anschaute, war ich erst einmal davon überrascht, wie seltsam mein Gesicht aussah. Wenn ich lache, habe ich fast die Augen zu – und die KI meinte anscheinend, dass ich immer so aussehe. Natürlich schaute ich mir die generierten Bilder mit einem kritischen Auge an und siehe da – auch bei mir waren Fotos vorhanden, die einen tiefen Ausschnitt, Körbchengröße D (die ich definitiv nicht habe) und hautenge Kleidung zeigten.

Allerdings muss ich auch sagen, dass ich in vielen Fotos mit dem Hoodie dargestellt war, den ich selbst trug. Vielleicht haben die App-Entwickler:innen sich also die Kritik von Brandee Barker vom Dezember und Co. zu Herzen genommen und Veränderungen an der KI und der App an sich vorgenommen. Dass sexistische Bilder trotzdem nun existieren, ist allerdings ein Fakt, den ich hier nicht unter den Teppich kehren möchte.

Lensa-App: KI’s manifestieren Vorurteile

Selbst bei Bildern mit hochgeschlossener Kleidung, nimmt sich die KI Lensa anscheinend heraus, die Frauen als Objekt der Begierde dazustellen und den male gaze anzuwenden. Dies sorgt nicht nur für Unbehagen bei der Frau, sondern auch für die Stärkung falscher Vorurteile gegenüber Frauen. Außerdem zeigt Lensa vermutlich den Blick, den die Gesellschaft auf Frauen hat – und wie diese will, dass Frauen aussehen.

Künstliche Intelligenzen können uns in gewissen Dingen vielleicht den Alltag erleichtern. Aber sie führen auch dazu, dass Stereotypen manifestiert werden und wir nicht mehr viel über unsere Handlung nachdenken. Natürlich ist man zu Beginn begeistert davon, wie gut man dank der KI aussieht. Aber schnell wird klar, dass hier angeblich mit Sexismus und ohne Konsens für Nacktfotos gearbeitet wird. Und das ist etwas, was man nicht so hinnehmen und unterstützen sollte.