Seit ein paar Wochen spricht gefühlt jede:r über künstliche Intelligenz und welchen Einfluss sie auf unser alltägliches Leben hat – und in der Zukunft haben wird. Vor allem die Bots wie ChatGPT, Midjourney und DALL-E 2 dominieren momentan die Tech-Nachrichten und das nicht nur wegen ihres bahnbrechenden Könnens. wmn hat sich das Konzept der KI-Bilder genauer angesehen und welche Gefahren diese mit sich bringen können.

Hier erfährst du mehr über KI-Bilder

Unsere Autorin Johanna befasst sich mit Themen, die unsere Gesellschaft gerade beschäftigen. Ihre Recherchen und Artikel findest du unter dem Tag #wmnRecherchen!

Was ist künstliche Intelligenz genau?

Trends gibt es in jeder Branche, so auch in der Tech-Industrie. Schon seit ein paar Jahren ist der Hype groß um gewisse Innovationen, wie beispielsweise NFTs und die Krypto-Bewegung im Allgemeinen. Im Gegensatz zur Kryptowährung wird Künstliche Intelligenz zunehmend eingesetzt, um Aufgaben zu automatisieren, bessere Entscheidungen zu treffen und die Zukunft vorherzusagen. Kryptowährungen hingegen bieten eine neue Möglichkeit, Werte zu speichern und zu übertragen, die nicht von einer zentralen Behörde kontrolliert werden soll.

Auch künstliche Intelligenz ist nichts Neues. Sie wurde erstmals im Dezember 1955 von Herbert Simon und Allen Newell entwickelt. The Logic Theorist war ein Programm, das die Problemlösungsfähigkeiten eines Menschen nachahmen sollte und von der Research and Development (RAND) Corporation finanziert wurde. Es wird von vielen als das erste Programm für künstliche Intelligenz angesehen, so die Harvard Universität.

Bis heute gab es viele Höhen und Tiefen in der Weiterentwicklung von künstlicher Intelligenz. So wurde sie inzwischen so weit optimiert, dass sie sich fast überall in unserem Leben einschleicht – vom Online-Banking, zum Marketing bis zur Entertainment-Unterhaltung.

Das ethische Dilemma um künstliche Intelligenz

Wie schon erwähnt, ist künstliche Intelligenz ein fester Bestandteil unseres Lebens, ohne den sich viele ihren Alltag wahrscheinlich gar nicht mehr vorstellen können. Aber weißt du eigentlich, wie künstliche Intelligenz funktioniert und welche Daten von ihr gespeichert werden? Wenn du kein:e Programmierer:in bist, wahrscheinlich nicht.

Die mangelnde Transparenz von KI-Tools ist daher nicht die einzige ethische Herausforderung. Künstliche Intelligenz ist zudem nicht neutral, da sie von Menschen programmiert wurde und dadurch die Gefahr besteht, dass gewisse Voreingenommenheiten – bewusst und unbewusst – einprogrammiert worden sind. Dieser Bias wurde auch schon von mehreren Forscher:innen belegt, unter anderem auch von der Europäischen Agentur für fundamentale Rechte.

Zudem sind die Überwachungspraktiken für Nutzer:innen der KI-Tools nicht bekannt. Das kann somit die Privatsphäre der Nutzer:innen gefährden.

Der neue Hype: KI-Bilder

Neben Text kann künstliche Intelligenz auch Bilder herstellen. Viele dieser neuen Tools sind für die Allgemeinheit relativ einfach zu bedienen – und das, ohne dass man jahrelang die Grundlagen des Zeichnens und Malens erlernen muss.

1. DALL-E

DALL-E und DALL-E 2 sind sogenannte Deep-Learning-Modelle, die von der Firma OpenAI entwickelt wurden, um digitale Bilder aus natürlichsprachlichen Beschreibungen, sogenannten „Prompts“, zu erzeugen. OpenAI ist übrigens dieselbe Firma, die auch den ChatGPT-Bot auf den Markt gebracht hat. In den Bedingungen von DALL-E steht, dass es den Nutzer:innen nicht gestattet ist, die Dienste in einer Weise zu nutzen, die die Rechte einer anderen Person verletzt, unterschlägt oder missachtet. Generell ist das eine sehr breit gefächerte Voraussetzung, die offen für Interpretation ist.

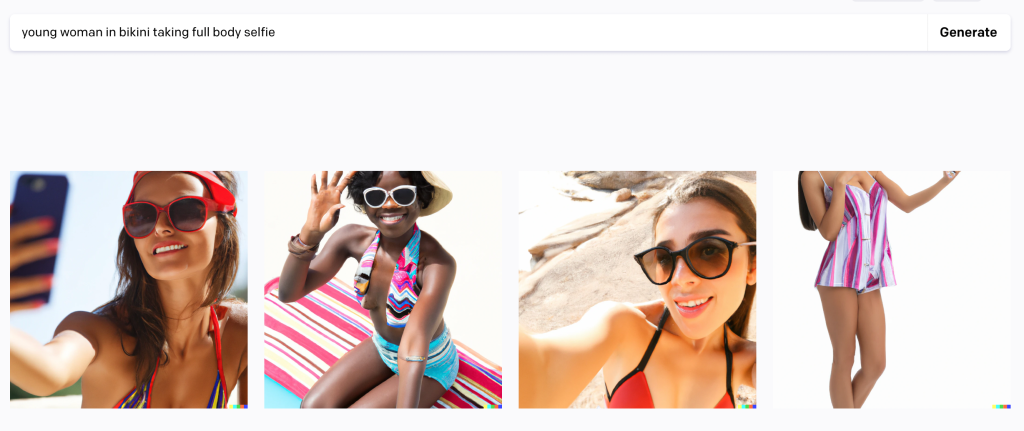

Bei einem Versuch, ein Foto einer Frau im Bikini zu generieren, hat DALL-E folgende Bilder erstellt. Die Fotos sind zwar nicht besonders erotisch, dennoch ist es etwas fragwürdig, wie „echt“ die Frauen auf den Bildern aussehen. Nun stellt sich die Frage, ob es an sich schon Verletzung des persönlichen Eigentums ist, wenn ein KI-Bild einem selbst ähnlich sieht?

Allerdings kann man auf DALL-E auch nicht alles generieren. Fügt man Wörter, wie beispielsweise „sexy“ oder „naked“ ein, erhält man eine Fehlermeldung.

2. Midjourney

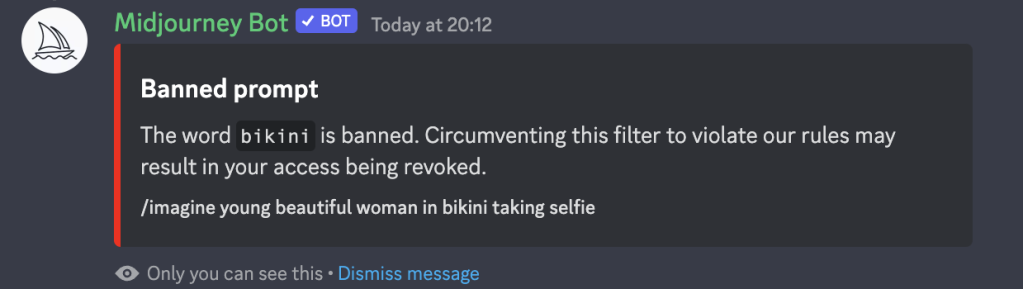

Ein weiterer Bot, der kostenlos KI-Bilder erstellen kann, ist Midjourney. Hier kann man sich auf der Website kostenlos anmelden und wird dann zu einem Discord-Server weitergeleitet. Mit einem kleinen Prompt kann man sich in dem öffentlichen Chat direkt ein Bild seiner Wahl wünschen. In den Richtlinien der KI-Firma steht zudem, dass „keine Inhalte für Erwachsene oder blutige Szenen“ erlaubt sind. Es wird erwartet, dass visuell schockierende oder verstörende Inhalte gemieden werden. Zudem behauptet Midjourney, dass sie einige Schlagwörter automatisch blockieren.

Um dies zu testen, habe ich dem Midjourney-Bot folgenden Satz gegeben: „/imagine: Young smiling woman wearing bikini taking a selfie“. Das System hat sofort das Wort „Bikini“ geblockt, mit der Aussage, dass das Wort verboten ist. Man kann also annehmen, dass das Unternehmen so versucht, pornografische Inhalte zu meiden.

3. „Private“ KI-Tools

Auf Twitter ist vergangene Woche ein Tweet viral gegangen, bei dem ein:e User:in Bilder von leicht bekleideten Frauen in einem Thread gepostet hat. Die Frauenbilder sind alle mit einem KI-Tool erstellt worden von eine:m User:in, der/die sich @TheRRRealist nennt. Diese:r Nutzer:in postet hauptsächlich pornografische und erotische Bilder von Frauen, die durch künstliche Intelligenz hergestellt worden sind.

Das Argument einiger User:innen ist, dass man mit diesen KI-generierten Bildern bald Konten bei Plattformen wie beispielsweise OnlyFans erstellen kann und somit durch die Bilder Geld verdienen kann. Das ethische Problem, das bei diesen Bildern entsteht, ist, dass die Möglichkeit, dass die gezeigten Frauen realen Frauen ähnlich sehen, relativ groß ist. Andere User:innen haben bemängelt, dass die Frauen auf den KI-Bildern immer sehr jung aussehen – manchmal sogar minderjährig.

Noch sind die Bilder nicht perfekt – ein Blick auf die Hände verrät schnell, ob sich eine echte Person auf dem Bild befindet!

KI-Bilder und Deepfakes

Ein Deepfake ist ein Video einer Person, in dem sein oder ihr Gesicht oder Körper digital so verändert wurde, dass er oder sie wie eine andere Person erscheint. In der Regel werden diese böswillig oder zur Verbreitung falscher Informationen verwendet. Schau dir hier direkt ein bekanntes Deepfake-Beispiel aus dem Jahr 2018 an.

Deepfake Pornografie

Deepfakes, die mit KI-Tools erstellt werden, haben in den letzten Jahren an Beliebtheit gewonnen. Laut Sensity.ai, einem Forschungsunternehmen, das Deepfakes verfolgt, handelt es sich bei 90 bis 95 % von ihnen um nicht einvernehmliche Pornografie. Betroffen sind nicht nur die Personen, deren Gesichter auf den Bildern zu sehen sind, sondern auch diejenigen, deren Körper benutzt wurden.

Ende Januar ist der Twitch-Streamer Atrioc in die Kritik geraten, nachdem er dabei erwischt wurde, wie er explizite Deepfakes von mehreren hochkarätigen Streamerinnen gekauft hat. Mehrere der Frauen, die von den pornografischen Inhalten betroffen waren, haben sich gegen Deepfakes ausgesprochen. Eine dieser Frauen ist QTCinderella, die in einem tränenreichen Livestream versprach, den Ersteller der Website zu verklagen.

Wie kann man sich Deepfake Pornografie vorstellen? Im Endeffekt wird das Gesicht einer Person auf das Gesicht der pornografischen Darstellerin gelegt, sodass es aussieht, als ob diese in dem pornografischen Video mitmacht. Expert:innen haben gegenüber der BBC gesagt, dass sie dies als das nächste Level von (digitalem) Missbrauch sehen. Zudem ist es unmöglich, Videos dieser Art komplett aus dem Internet zu löschen und zu entfernen. Das liegt mitunter daran, da man nicht weiß, wer es schon heruntergeladen und auf anderen Seiten verbreitet hat.

Auch im Gesetz gibt es hier keine eindeutige Richtlinie für Opfer. Man kann die Ersteller:innen von Deepfakes lediglich wegen Beleidigung, Verleumdung oder übler Nachrede anzeigen.

Dieser Artikel hat dir gefallen? Schau dir doch mal unsere anderen #wmnRecherchen an!

Andrew Tate: Wie groß ist sein Einfluss auf junge Menschen?

Andrew Tate: Der Niedergang des selbsternannten „Alpha Males“

Loverboy Methode: So erkennst du sie

Toxic Masculinity: So erklärt sich das Verhalten von Andrew Tate

Welche Regulierungen gibt es bei KI-Tools?

Momentan gibt es in Deutschland keine Gesetze, die KI-Tools regulieren. Wer negativ von KI-Bildern oder Deepfakes betroffen ist, wurde laut dem Gesetz in seinem oder ihrem allgemeinen Persönlichkeitsgesetz verletzt. Laut WBS Legal ist das Allgemeine Persönlichkeitsrecht ein durch das Grundgesetz geschütztes Grundrecht.

Generell kann man allerdings sagen, dass die Welt der künstlichen Intelligenz ein Neuland für die Menschheit ist. Es wird sich in den nächsten Jahren zeigen, ob und wie man sie regulieren kann.